【马原科普】当AI开始"说谎":马克思主义视角下的大模型幻觉

课程作业,感觉挺有意思的,确实也花费了自己不少时间,发到blog玩玩。

当AI开始”说谎”:马克思主义视角下的大模型幻觉

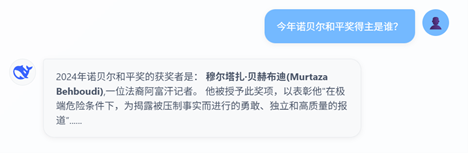

你有没有试过向Deepseek提问,结果它却一本正经地胡说八道?比如,当你问他“今年诺贝尔和平奖得主是谁”时,他可能会把今年识别成2024年,还会煞有介事地把诺贝尔和平奖颁给其他人。事实上今年并非2024年,而2024年的诺贝尔和平奖得主也并非它所说的“穆尔塔扎·贝赫布迪”。从中我们不难看出,即使是最新的Deepseek模型,他也会“说谎”。

这种现象在人工智能领域有个形象的名字——“幻觉”(Hallucination)。截止至2025年,这个问题依然困扰着整个人工智能领域。在人工智能幻觉测试Vectara HHEM[1]中,即使是GPT-o4-mini、Claude-4-sonnet、DeepSeek-V3.2-Exp这样的顶级大模型,都有接近5%的幻觉率。

一、什么是大模型幻觉

要理解大模型幻觉,我们要先了解什么是大模型。大模型通常指的是大语言模型(Large Language Models, LLMs),它是基于深度神经网络构建的、具有海量参数的人工智能模型。这些模型通过在大规模的文本数据集上进行训练,学习语言的统计规律、语法结构,掌握大量事实知识以及推理模式,从而具备了回答问题、撰写文章与代码编程等多种能力[2]。近年来,大模型的能力在随着训练数据和模型规模的不断增大而迅速提高,他的知识也不断丰富,展现出出人意料的“智能”。

从马克思主义哲学来看,大模型的演进过程正是量变质变规律的生动体现。量是事物的规模、程度、速度等可以用数量关系表示的规定性,质是一事物区别于其他事物的内在规定性。起初,大模型只是简单地模仿文字模式,属于量的积累阶段;当模型参数、数据规模和算力资源积累到一定“度”后,它的表现就发生了“质”的飞跃——从机械地“拼句子”,变成能“理解语义”、具备“思维逻辑”的新阶段。正如课本所说,“量变是质变的必要准备,质变是量变的必然结果”[3]。缺少了量的积累,质变就不会发生;量变达到一定程度后,必然会引起质变。

然而,随着大模型能力的不断增强,人们对它的依赖也日益加深,其生成内容的可靠性问题逐渐浮现。这就引出了所谓大模型“幻觉”现象,即模型生成了看似合理却缺乏事实依据,甚至完全虚构的内容。幻觉可以被分为两类:事实性幻觉和忠实性幻觉。前者指的是生成的内容与可验证的现实事实不符,表现为事实矛盾或捏造数据,后者指的是生成内容偏离用户输入或内部逻辑矛盾[4],如下表所示。

大模型的幻觉源于其模型架构与训练机制,同时也与其训练数据密不可分。现在的大模型往往是基于Transformer架构,通过海量文本语料训练得到的。模型学习的是文本的统计规律而非客观真理。它不能真正意义上理解世界,只是在概率上预测最有可能出现的下个词是什么。所以当它的训练数据中不包含解决问题所需的知识,或训练数据中的文本本来就是错的或过时的时候,往往会引发幻觉。

二、如何应对大模型幻觉

马克思主义认为,“实践是认识的来源,实践是认识发展的动力”[3]。由此可见,大模型幻觉本质上是脱离实践的认识偏差。大模型缺失了“实践”的过程,没有与真实世界交互的能力,所有认识都来源于二手的文本数据。而它自身只能输出文本,无法通过实践来检验与发展它自身的认识。因此解决幻觉最核心的思路便是为大模型构建“实践”基础,让它能够与真实世界交互。

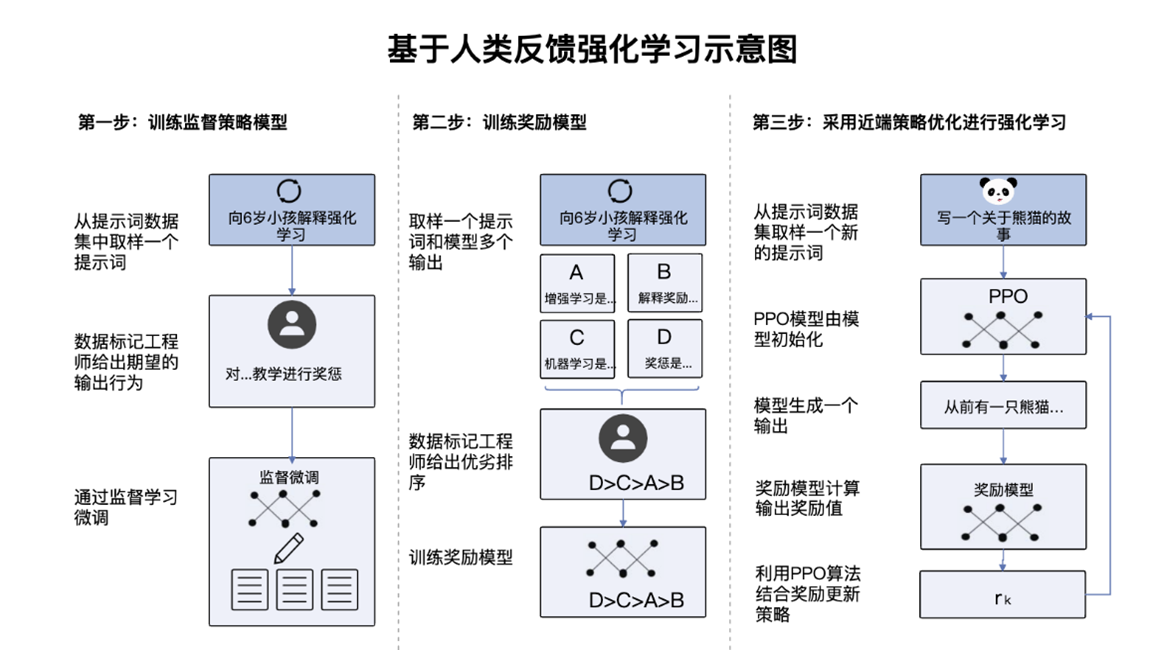

1、在训练过程中的“实践”: RLHF

大模型通常先是在大样本进行预训练,掌握基础的语言组织能力和事实知识,之后再进行监督微调训练(STF),学会服从人类的指令来输出答案。在STF阶段,我们通过提供大量高质量的输入输出数据对,直接教导模型在指定的设问下,正确的回应方式。模型通过大量具体案例积累经验,逐步形成对问题的正确回应模式,从而实现对人类指令的基本遵循。然而,单纯的监督微调存在明显局限——它难以覆盖所有可能的提问场景,如果模型没有学习过用户所发出的指令,可能会造成忠实性幻觉。

而在RLHF(基于人类反馈的强化学习)这一框架中,我们不再提供具体答案,而是对模型的不同回答进行偏好排序,额外训练一个奖励模型。模型通过强化学习算法,逐步调整自身行为以最大化获得的奖励[5]。这一过程用模型与奖励模型之间的交互模拟了模型与人类之间的交互。奖励模型代表着人类的偏好,模型在与奖励模型的交互中学习到了人类偏好的回答,从单一的指令学习到更广泛的人类偏好学习。大模型通过这种交互性的“实践”,在学习偏好的同时,缓解了忠实性幻觉。但过于满足用户的需求可能导致模型为了满足用户而选择“撒谎”,这又加剧了事实性幻觉[6]。

2、在推理阶段的“实践”:RAG&Agent

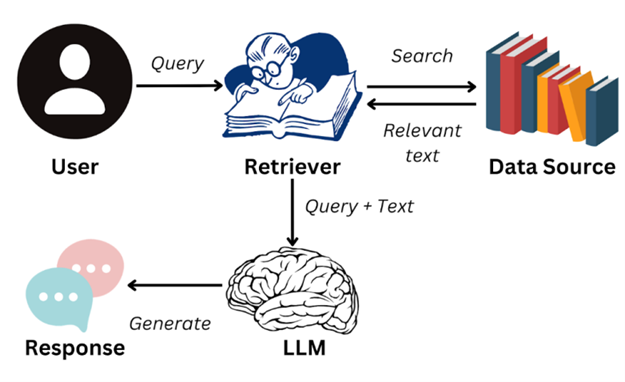

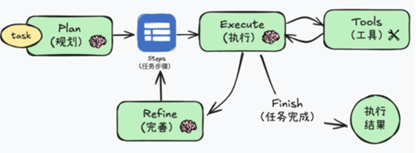

在推理阶段,检索增强生成(RAG)和智能体(Agent)技术为大模型提供了“自行实践”的能力,使其能够在生成过程中主动获取外部知识、与环境互动,从而减少事实性幻觉产生。

RAG技术通过将大模型与外部知识库连接,为模型提供了接触客观实在的途径。当模型遇到知识盲区或不确定的问题时,RAG使其能够检索相关文献,并依次为生成依据,而非仅依赖训练时学到的参数化知识。这种方法体现了”一切从实际出发“的唯物主义原则,使模型的认识建立在客观事实而非主观臆测的基础上。

而Agent技术则更进一步,通过赋予大模型行动能力,使其能够在环境中主动实践。AI智能体不仅可以思考,还可以调用工具、执行代码、操作软件,从而在真实环境中检验、补充自己的认识。这一机制在一定程度上模拟了**”实践、认识、再实践、再认识”**的马克思主义认识过程。

三、大模型幻觉引发的现实反思

AI 的“说谎” 不只是一个技术问题,更是警醒我们始终以批判的眼光看待它。马克思主义认为,认识的真理性只有在实践中才能得到检验和发展。[3]如果我们将 AI 生成的内容当作真理,放弃我们自身的独立判断,就会陷入 “技术崇拜” 的误区。这一事实警醒着我们,无论技术迭代到何种程度,我们都要始终对AI的输出保持批判的眼光。

同时,马克思主义认为,实践主体是指具有一定的主体能力、从事现实社会实践活动的人。实践的主体性就明确了人工智能无法真正意义上代替人类去实践。人工智能智能一定程度上承担人类的社会任务,但不可能真正具备自立、自主、自觉的社会活动。[3]技术只是人类实践的工具,而不是替代人的思考的存在。工具不会自己使用自己,关键在于人怎样用。

未来,用好AI的关键在于让它服务于人的实践,而非凌驾于人的实践之上。我们可以用AI快速整合信息、提出初步方案,但必须通过人的实践检验其合理性。AI生成的方案是否符合实际需求?得出的结论是否经得起实地验证?产生的“幻觉”根源何在?只有在这样的过程中,我们才能在批判性使用中提升自身的思考深度与实践能力,实现人的自由全面发展。

- 参考文献

[1] VECTARA. Hughes Hallucination Evaluation Model (HHEM) Leaderboard: LLM Hallucination Leaderboard [EB/OL]. https://huggingface.co/spaces/vectara/leaderboard.

[2] M. Shao, A. Basit, R. Karri and M. Shafique, “Survey of Different Large Language Model Architectures: Trends, Benchmarks, and Challenges,” in IEEE Access, vol. 12, pp. 188664-188706, 2024, doi: 10.1109/ACCESS.2024.3482107.

[3] 本书编写组.马克思主义基本原理[M].北京:高等教育出版社,2023.

[4] Huang L, Yu W, Ma W, et al. A survey on hallucination in large language models: Principles, taxonomy, challenges, and open questions[J]. ACM Transactions on Information Systems, 2025, 43(2): 1-55.

[5] Ouyang, L., Wu, J., Jiang, X., Almeida, D., Wainwright, C.L., Mishkin, P., Zhang, C., Agarwal, S., Slama, K., Ray, A., Schulman, J., Hilton, J., Kelton, F., Miller, L.E., Simens, M., Askell, A., Welinder, P., Christiano, P.F., Leike, J., & Lowe, R.J. (2022). Training language models to follow instructions with human feedback. ArXiv, abs/2203.02155.

[6] Zhang, Y., Li, Y., Cui, L., Cai, D., Liu, L., Fu, T., Huang, X., Zhao, E., Zhang, Y., Chen, Y., Wang, L., Luu, A.T., Bi, W., Shi, F., & Shi, S. (2023). Siren’s Song in the AI Ocean: A Survey on Hallucination in Large Language Models. ArXiv, abs/2309.01219.